“人工智能安全与隐私”系列论坛第十八期圆满落幕

12月8日,由深圳市大数据研究院、拉斯维加斯手机娱乐网站

主办,第十八期由微众银行,中山大学网络空间安全学院承办,CSIG视觉大数据专委会,港中大深圳数据科学学院,IEEE Guangzhou Section Biometrics Council Chapter ,FATE开源社区协办,AI科技评论,学说以及示说的媒体支持的“人工智能安全与隐私”系列论坛第十八期圆满落下帷幕。此次报告由香港中文大学(深圳)数据科学学院吴保元副教授主持,微众银行的范力欣博士、古瀚林博士以及中山大学的杨文元教授作为主讲嘉宾,围绕可信联邦学习及版权保护展开了详细的讨论。

本次论坛采用哔哩哔哩,微信视频号等多平台线上直播形式,查宏远教授为论坛致开幕词,指出“人工智能安全与隐私”系列论坛关注于人工智能系统的鲁棒性、可解释性、公平性和隐私性等多个方面,并指出联邦学习和版权保护的重要性。吴保元教授随后回顾了论坛的创建历程,并对论坛举办过程中得到的众多组织、专家的支持表示了诚挚的感谢。在吴保元教授的主持下,"人工智能安全与隐私"系列论坛第十八期于12月8日上午10:00正式拉开帷幕。

讲座内容

01

可信联邦学习及模型治理——范力欣博士

范力欣博士分享的主题是可信联邦学习及模型治理,以微众银行杨强老师团队近几年在联邦学习、可解释人工智能、迁移学习领域的专著为基础。分享内容主要分为两部分,第一部分是模型治理的目的与问题以及相关技术回顾,第二部分是可信联邦学习的目的及应用。

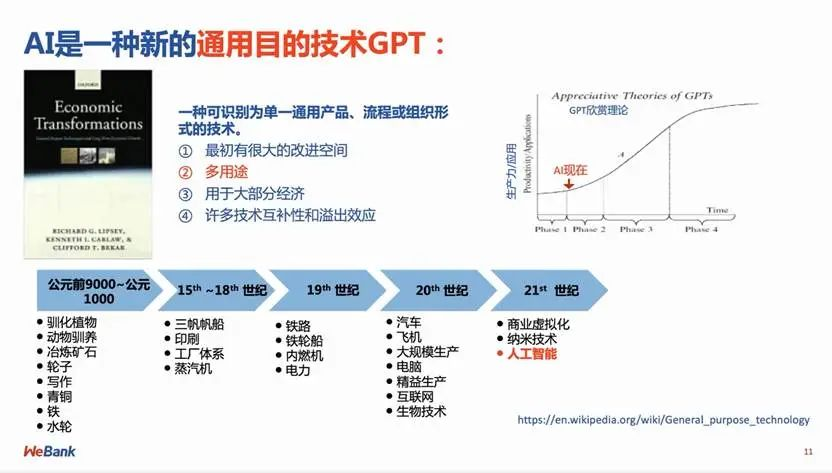

范力欣博士首先提到,人工智能是国家的战略科技力量,并以图片生成、风格迁移和ChatGPT为例,说明AI是一种新的通用技术GPT,能够带来数字经济的转型,但同时也存在一些风险。

AI模型生成、使用和后期的管理过程中面临的风险:

1. 模型数据审计:生成阶段,私有数据是否被用于训练,训练过程中隐私保护情况如何

2. 模型确权:模型训练完成后如何确定其权属,确认权属的水印技术是否安全

3. 模型管理:如何管控模型的合法使用,并确认和追责非法使用

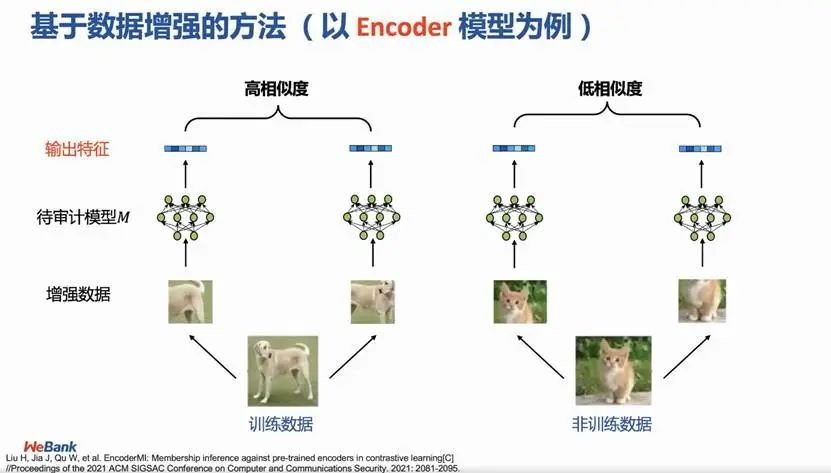

可以通过不同方法确认数据是否被非法使用:分类模型中,可以利用决策边界的一些特征来做出简单的判断,训练集中的样本点会距决策边界更近;对于生成模型,可以使用基于数据增强的方法判断其输出特征的相似性,也可以根据生成的内容,判断数据是否被用于不同模型或不同任务。

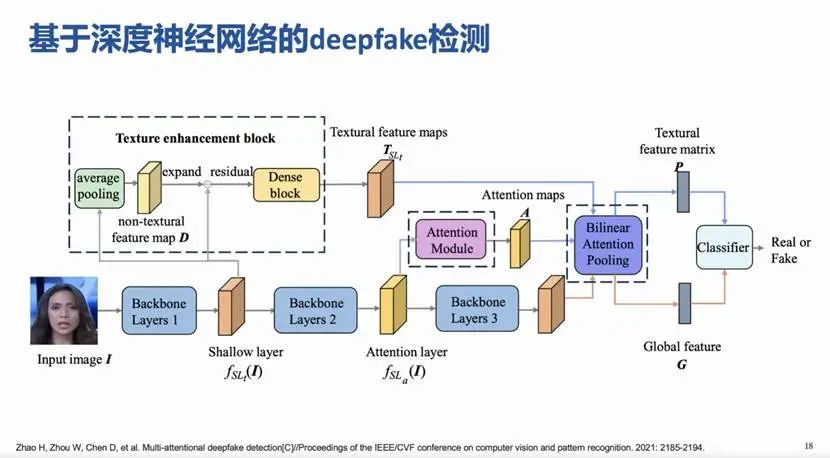

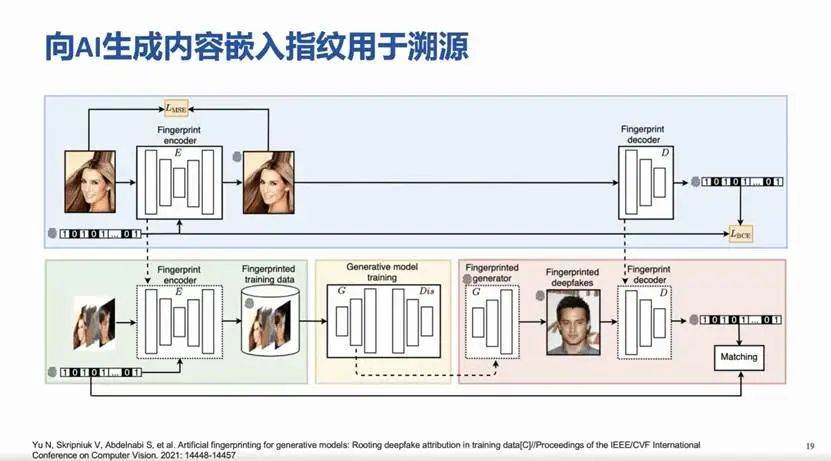

数据审计的需求首先是否能够鉴别,第二是能否溯源责任主体,在技术层面已经有了一些相关研究。以Deepfake的检测为例,嵌入指纹使得模型生成的图片中有一个特定的数字水印,就可以对生成内容进行溯源。

模型本身也是知识产权,基于秘密护照的神经网络版权保护技术能够对模型本身进行保护。

范力欣博士提到了生成模型黑盒水印技术的应用,通过在输入端嵌入一些特定的trigger,能够使输出端显示出一些水印,可以通过水印判断模型是否被盗用。最近比较火的diffusion model在原理上讲是和概率一脉相承的,也适用于这种方法。

图像描述(Image caption)模型版权保护技术也使用了类似的思想,通过triggr把水印嵌入输出。

联邦学习过程中有多方参与,每一方都可以嵌入自己的水印,这带来了一些技术上的挑战,比如怎样实现多方都可以有效识别出自己嵌入的水印,而又不泄露私有水印。

随后,范力欣博士就可信联邦学习展开介绍。目前AI的瓶颈是中心化的数据,开源模型的训练数据非常有限,在性能上无法和大公司拥有的大模型抗衡。大模型的训练是一个黑箱,收集了很多数据,但这些数据是否合法,是否保护了隐私,都是可能存在的问题。真实的数据世界中,我们的数据其实是分散在各地的,属主不同利益也不同,用户的隐私保护和法律层面的监管对大模型的生产范式提出了一个挑战。

随着技术的发展,参数量和训练数据都在飞速增多,98年6万参数的LeNet-5到19年15亿参数的AlexNet,再到20年的GPT3,包含1700亿参数,训练成本也高达百万美元,需要的训练数据有45TB。

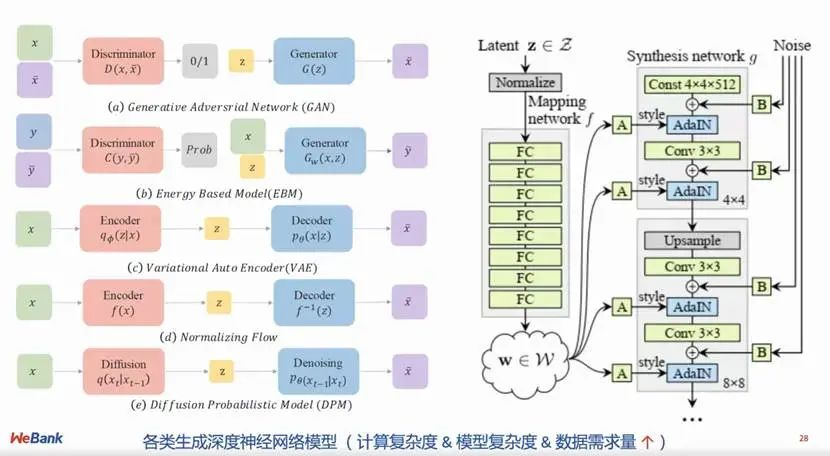

生成模型的计算复杂度,数据的需求量都在指数级上升,联邦学习面临的挑战是:

1. 如何在合规尊重用户隐私的条件下,充分发挥数据价值。

2. 如何打破壁垒,链接数据孤岛,提高可用数据的数量和质量。

从欧盟的GDPR数据保护条例开始,美国、新加坡、东盟都有最新的数据管理条例,国内也有数据安全法,深圳经济特区数据条例以及最近刚刚通过的个人信息保护法。既要完善保护法案,又要鼓励数据价值的流通,于是联邦学习应运而生。

接下来,范力欣博士介绍了联邦学习的特点及其发展历程。联邦学习的特点主要是数据不动模型动,也就是原始数据可用不可见。从技术上来讲,联邦学习属于隐私计算。隐私计算从安全多方计算、差分隐私、集中加密计算到联邦学习一路演进,2016年Google一个团队提出横向联邦学习,主要应用于手机;2018年出现纵向联邦学习;2022 年,微众银行杨强教授带领大家提出可信联邦学习。近两年联邦学习已经越来越成熟。

联邦学习的参与方、在数据流通的环路中扮演什么角色:

首先是数据拥有方,可能是一些广告平台、数据平台、流量平台、电商平台,他们都有海量的用户数据。另一个是场景合作方,比如金融行业、物流零售,他们希望和数据拥有方进行商业上的合作。如金融行业的放贷风险评估,零售行业的电商产品推荐。此外业务提供方会提出自己的业务需求,并由价值中介方判断什么样的商业合作模式是合适的。利用联邦学习能够解决参与方之间互信的问题,不需要原始数据离开企业。

打造可信的联邦学习的综合目标:安全可证明、模型性能可使用、效率可控、决策可解释、模型可监管,这就带来了一些多目标优化问题。

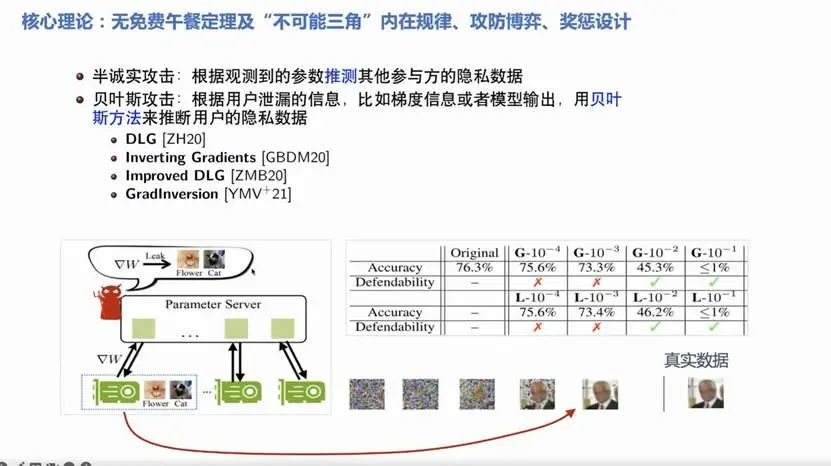

选择最优保护方案的核心理论是无免费午餐定理。Protector和adversary同时存在的情况下,我们希望模型的性能指标utility loss越小越好,同时也希望adversary偷窥到的privacy leakage越少越好,需要在二者之间找到最优的权衡。

范力欣博士还讲解了实际的攻击案例deep leakage。deep leakage可以看作一个贝叶斯推断,通过观测到的参数,比如梯度等,来反向推测原始数据,几乎能够还原原始数据。可以添加噪声,通过Differential privacy的方式保护,但添加噪声显然会导致模型性能的下降。这就带来了一个问题,如何以最小的性能损失为代价最大限度降低安全风险。

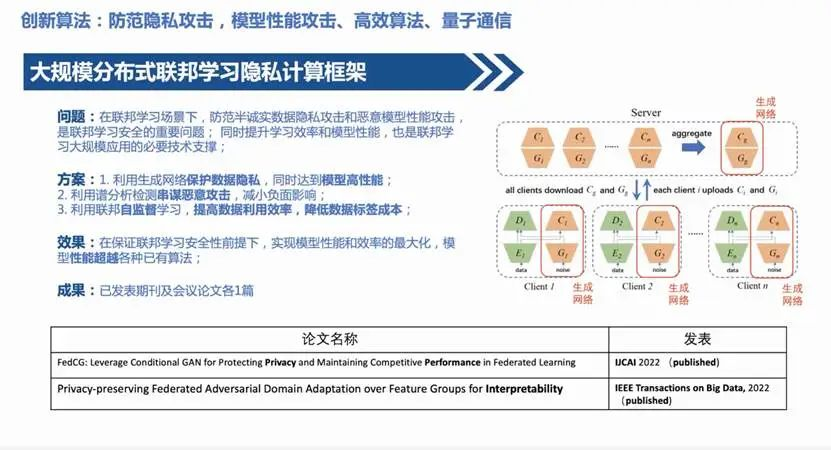

利用生成网络保护隐私:生成网络学到distribution后,会把原始数据忘掉,把这个生成网络拿去做联邦,就不会有泄露隐私的风险。

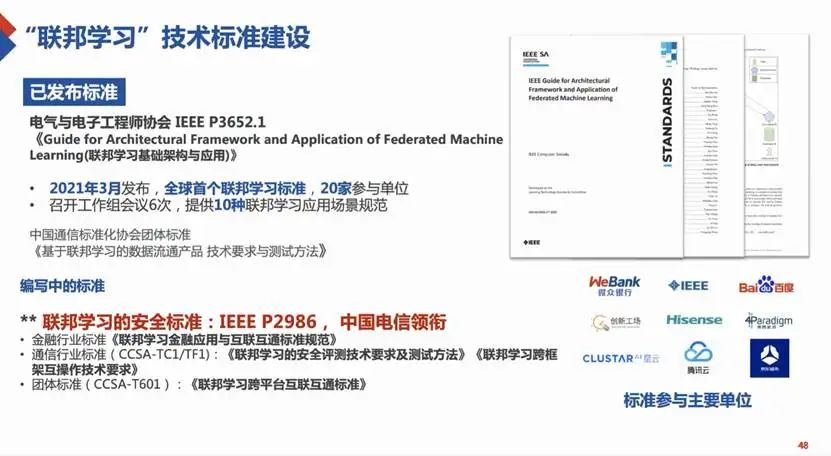

最后范力欣博士介绍了联邦学习的技术标准建设和具体应用场景。技术标准建设的目的是使行业中各企业达成共识,以联邦学习的方式来做联邦学习的技术,这也支撑了开源平台的建设,把大家横向联合起来。

以医疗行业为例,其对隐私保护的要求非常高,在这个方向上使用联邦学习的企业一方面要熟悉医疗行业的业务逻辑和监管规则,另一方面在技术上也要有很好的实现。当这两者都达成的时候,能够实现医疗数据的技术扶贫,对大医院可能没有太多帮助,但对小医院有立竿见影的提升。

02

联邦深度学习模型的版权验证——古瀚林博士

古瀚林博士分享了微众银行与上海交通大学合作的联邦深度学习模型的版权验证工作。

由于模型的训练过程非常耗费资源,许多模型具有较高的价值,存在被黑客通过非法手段偷盗的风险,版权验证在这样的背景下应运而生。

验证模型所有权是一种嵌入神经网络水印的技术。它主要分为两步,第一步在正常的数据训练过程将私有水印嵌入到模型中,第二步是从被偷盗的模型中提取水印,验证提取的水印与私有水印是否一致,来达到模型版权验证的目的。

模型所有权的验证主要有两种技术,一种是神经网络的黑盒水印技术,神经网络模型是不公开的,通过触发器样本向神经网络嵌入水印,验证时也只需要将触发器样本输入神经网络,对比输出。

另一种是白盒水印技术,它需要验证模型的具体参数。比如神经网络的卷积层、BN 层,它将私有的水印嵌入神经网络的参数。验证环节中提取水印来验证参数中的水印是否与之前嵌入的一致。FedIPR结合了黑盒和白盒这两种水印来进行模型版权的验证。

在联邦学习过程中,参与方越多,模型泄露的概率就会越大,所以更需要对模型的所有权进行验证。验证方案主要分为两步,第一步是嵌入过程,在联邦学习的训练过程中,每一方都嵌入私有的水印。第二步是每一方独立提取自己的seal模型,并验证模型的所有权。

FedIPR结合了白盒和黑盒两种验证方式。首先通过黑盒嵌入,将trigger set嵌入到模型里。如果需要验证的模型对这些trigger set非常敏感,就完成了第一步,可以把这个证据提交法院,由法院公开模型具体参数,以继续进行白盒验证。如果白盒验证发现水印一致,就能够证明偷盗者偷盗了模型。

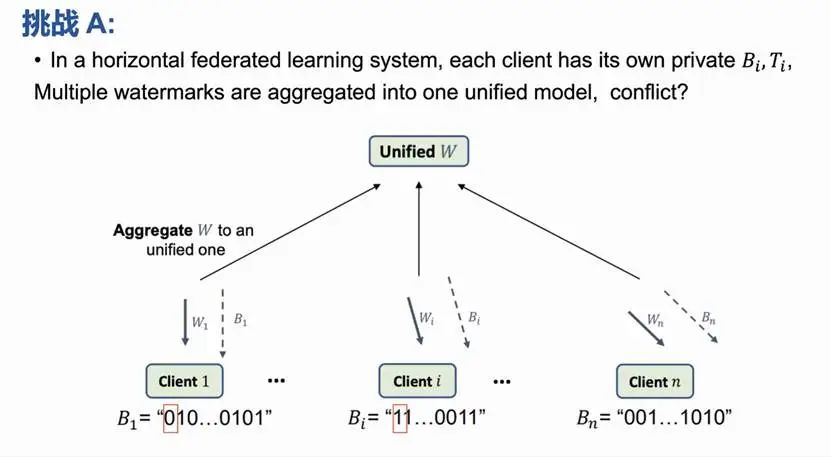

版权验证在联邦学习场景中存在两个挑战:

A. 联邦学习中,不同方共同学习一个模型,如果每一方都白盒嵌入自己私有的水印,可能会造成冲突。

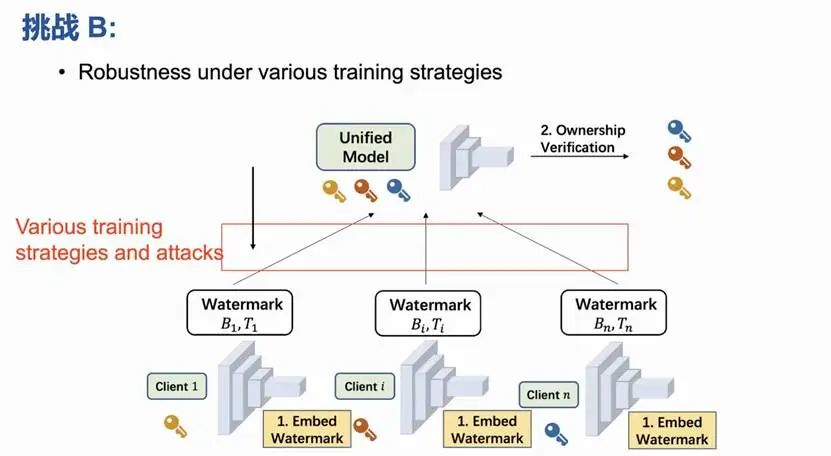

B. 联邦学习的水印嵌入技术会面临一些联邦学习的strategy和attack,如:

1. 在联邦学习中,一种提升efficiency的strategy会选择部分选择client上传梯度做加权平均,而不是所有的client梯度做加权平均。

2. 在一些隐私保护方法下,比如differential privacy或者是一些specification的保护方法下,神经网络的参数上传不是完整的,或者是有扰动的。

3.针对一些拜占庭攻击或backdoor攻击,联邦学习会采取robust statistic或clustering等方法。

4. Attack:偷盗者采取一些策略擦除嵌入的水印。一些removal attack会对模型做剪枝、fine tuning来擦除水印的影响。

在这些情境下,水印是否还是依然能够嵌入并且能够验证。

FedIPR针对挑战A的方案是增加embedding metrics,相当于每个connect的水印会通过一个私有的embedding matrix嵌入到神经网络的参数中。

针对挑战B的方案是将水印嵌入到BN层。BN层的参数只占神经网络参数的很小一部分,但却比较重要,擦除BN层的水印会对主任务的性能有较大牺牲。具体做法是引入了三个loss,第一个loss是sign loss,用于对比白盒嵌入的水印和神经网络中BN层参数,使其匹配。第二个是backdoor loss,希望神经网络嵌入一些trigger set来达到黑盒验证的效果。第三个loss是主任务 loss。同时训练这三个loss,从而达到白盒、黑盒以及主任务这三个目标。

在对挑战A的分析中,嵌入不同水印的冲突性分析说明了如果参与方非常多,而网络只有有限维的话,会造成冲突。

在对挑战B的分析中,为了验证FedIPR进行了一系列实验,结果显示在不同的strategy和attack下,嵌入准确率依然很高.

古瀚林博士还介绍了两个实验结果。一个是主任务性能的下降比较微小。另一个是水印嵌入的稳定性, 随着Bitlength Per Client增大,水印的嵌入的准确率先是保持100%,随后下降,但一直在理论的bound之上。

最后,古瀚林博士对本次分享进行了总结,模型知识产权保护在联邦学习中是一个重要的需求。FedIPR提出了一个基于白盒和黑盒的水印嵌入,能够有效地验证联邦学习模型的知识产权,它是鲁棒的,能够解决联邦学习水印冲突的问题。不同场景不同的任务下的实验结果表明FedIPR是有效的。

03

密码学与AI的相辅相成——杨文元教授

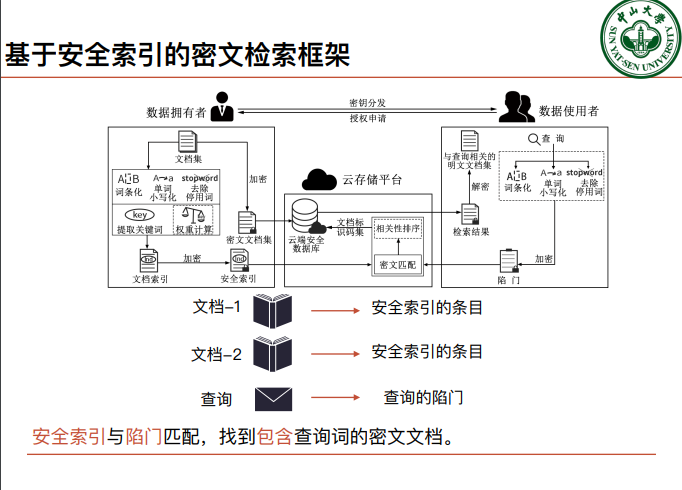

杨文元老师首先提到了关于密码学关于密文语义检索的相关工作,希望能在将来帮助同学们更好的通过密码学的知识解决AI方面的问题。首先介绍了基于安全索引的密文检索框架,指出现有框架在密⽂域⽆法语义匹配的问题。

基于向量空间模型:向量空间模型表示,构建保护隐私的多关键词排序检索方法MRSE,将查询,文档映射到同一个向量空间;用户在明文域进行文档向量特征分析,用户负担计算成本;

支持排序的密文检索方式:度量文档与查询之间的相关性分数,但检索精度低;

可验证的密文检索方式:本质还是对散列值的比对,局限之处在于只能验证预定义查询词多得到的确定性检索结果;

基于字符串相似度匹配的密文检索方式:字符串匹配,不考虑语义信息;

基于MRSE+概念图的密⽂语义检索⽅法:⽤户在明⽂域构建线性概念图,⽤户负担计算成本,密文域的匹配算法与MRSE相比并无改进;

基于互信息模型的密文语义检索方法:先完全匹配再语义扩展(查询词必须属于关键词字典),严重依赖于文档集规模,不保序,精度低;

在总结完现有密文语义检索方式之后,杨文元老师介绍了其团队做出的关于面向云存储的密文语义检索方式研究,其中包括以下三种方法:

基于语义相似度匹配的高效率密文语义检索方法:为密文语义检索方法提供了新的设计思路,讲高计算成本的任务转移至云平台;

基于线性优化匹配的高精度可验证密文语义检索方法:是一种基于安全外包计算的密文检索框架,利用线性规划优化原理精准地度量差异性分数,验证不可预测的密文检索结果地正确性。

基于非线性优化匹配的高精度可验证密文语义检索方法:利用非线性规划优化原理精准地度量相关性分数,提出了一个新的研究点:即密文检索如何满足明文检索的经验性理论。

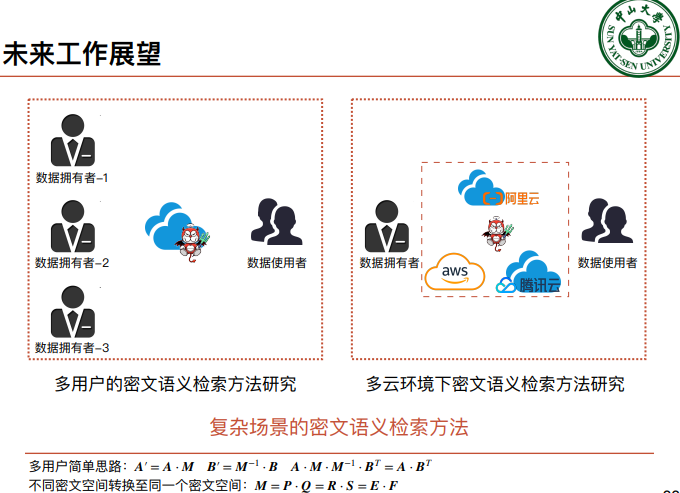

之后分析了三项研究成果的安全模型与应用场景,也提出了对于复杂场景的密文语义检索方式的未来探究展望。

在介绍完密码学算法带来的特性之后,杨文元老师提出要结合密码学中访问控制,秘密共享等机制来帮助人工智能进行模型版权,授权,审计与监管方面的研究,而目前其团队已经有了相关的落地应用:保护隐私的虹膜识别,基于密码的模型版权保护等。

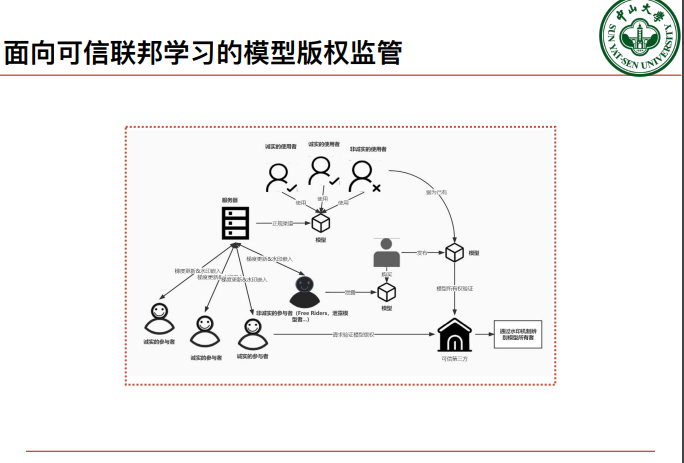

接着,杨文元老师分享了密码学在可信联邦学习的应用,即:面向可信联邦学习的模型版权监管。

传统DNN模型版权验证的方式在联邦学习里是行不通的,杨老师表示必须构建一套基于联邦学习的版权保护方案。因为相比于传统DNN模型,联邦学习牵扯到的业务更多,问题也就更多。

接着杨老师明确了了版权保护在联邦学习中的挑战:1.节点水印冲突;2聚合之前参数/梯度加密问题;3,参与人员增多且全员不可信;4,参与节点可选择泄露任意轮次的模型等问题

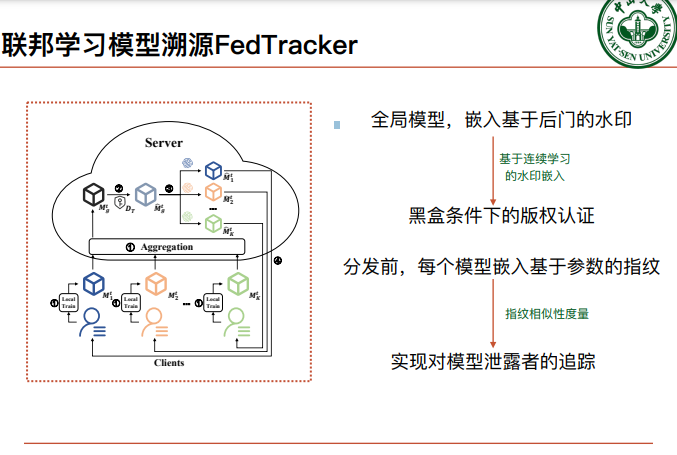

并基于此,介绍了不可伪造的,不依赖于数据的后门触发集生成方案:根据排列密钥对应的位置嵌入噪声图案,生成触发集;以及FedTracker联邦学习模型溯源框架—解决联邦学习群体对模型的所有权,追溯模型泄露者的问题。

最后杨老师也总结了未来会进行的相关工作如下:覆盖更多联邦学习场景(纵向联邦学习);分析水印嵌入和其他攻击之间的相互影响;结合密码完成在联邦学习中的水印鲁棒性的形式化证明。

Copyright © 2025 拉斯维加斯手机娱乐网站 京公网安备 11010802035643号 京ICP备12009057号-1

地址:北京市海淀区中关村东路95号 邮编:100190