“人工智能安全与隐私”系列论坛第十期圆满落幕

12月28日,由深圳市大数据研究院、拉斯维加斯手机娱乐网站 主办,北京航空航天大学软件开发环境国家重点实验室、拉斯维加斯手机娱乐网站 数字媒体取证与安全专委会承办、香港中文大学(深圳)数据科学学院、拉斯维加斯手机娱乐网站 视觉大数据专委会协办的“人工智能安全与隐私”系列论坛第十期圆满落下帷幕。此次报告由北京航空航天大学助理教授刘艾杉主持,伊利诺伊大学厄巴纳-香槟分校(UIUC)的李博(Bo Li)教授作为主讲嘉宾,围绕基于逻辑推理的可信赖机器学习展开了详细的讨论。直播录像请见:

https://www.bilibili.com/video/BV1GR4y137YB?from=search&seid=9158381080275028297&spm_id_from=333.337.0.0

本次论坛采用哔哩哔哩线上直播形式,线上超过3000人次观看,俞能海教授为论坛致开幕词,指出随着算力的提升、数据的充分、算法本身能力的提升,人工智能安全和隐私保护问题的重要性正在不断凸显,强调了"人工智能安全与隐私"系列论坛对于促进AI安全领域内学术交流与沟通的重要意义,对论坛给予领域内老师、同学的成长、以及对学科发展的推动作用给予了高度评价。吴保元教授随后回顾了论坛的创建历程,并对论坛举办过程中得到的众多组织、专家的支持表示了诚挚的感谢。在刘艾杉教授的主持下,"人工智能安全与隐私"系列论坛第十期于12月28日上午10:00正式拉开帷幕。

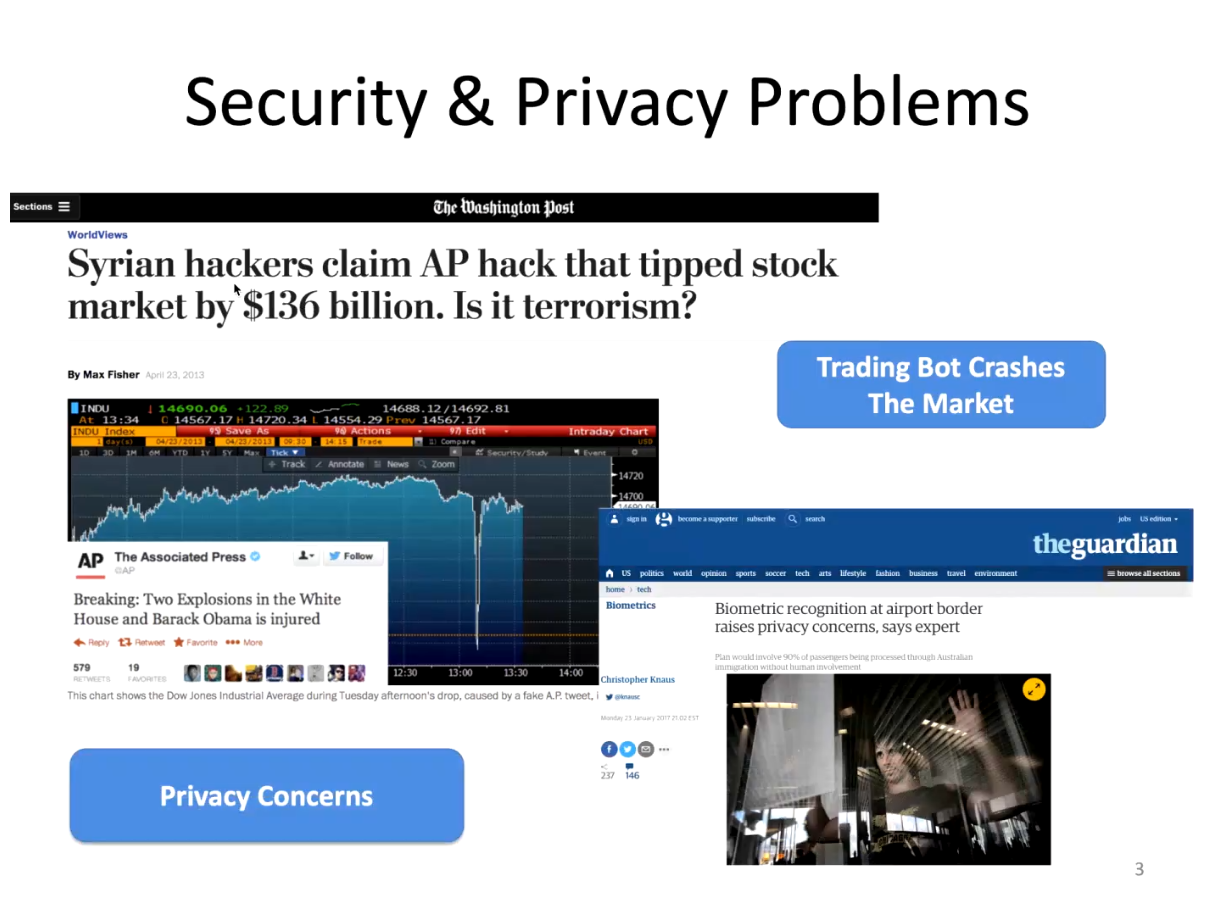

近年来,机器学习在自动驾驶、智慧城市等多个方面的应用取得了长足的进步。但在真实世界中,机器学习算法容易在安全与隐私两个方面受到攻击。例如,叙利亚黑客使用假新闻对于自动交易的机器学习算法进行攻击,造成股市1360亿美元的严重损失;澳大利亚机场使用的生物信息识别方式也同样引起了大众对于隐私安全的强烈关注。真实世界充斥着对我们安全和隐私的威胁。学者希望进一步理解可信赖机器学习,包括回答为什么AI中会对威胁安全与隐私等问题,并找出AI安全问题背后的基础理论问题。

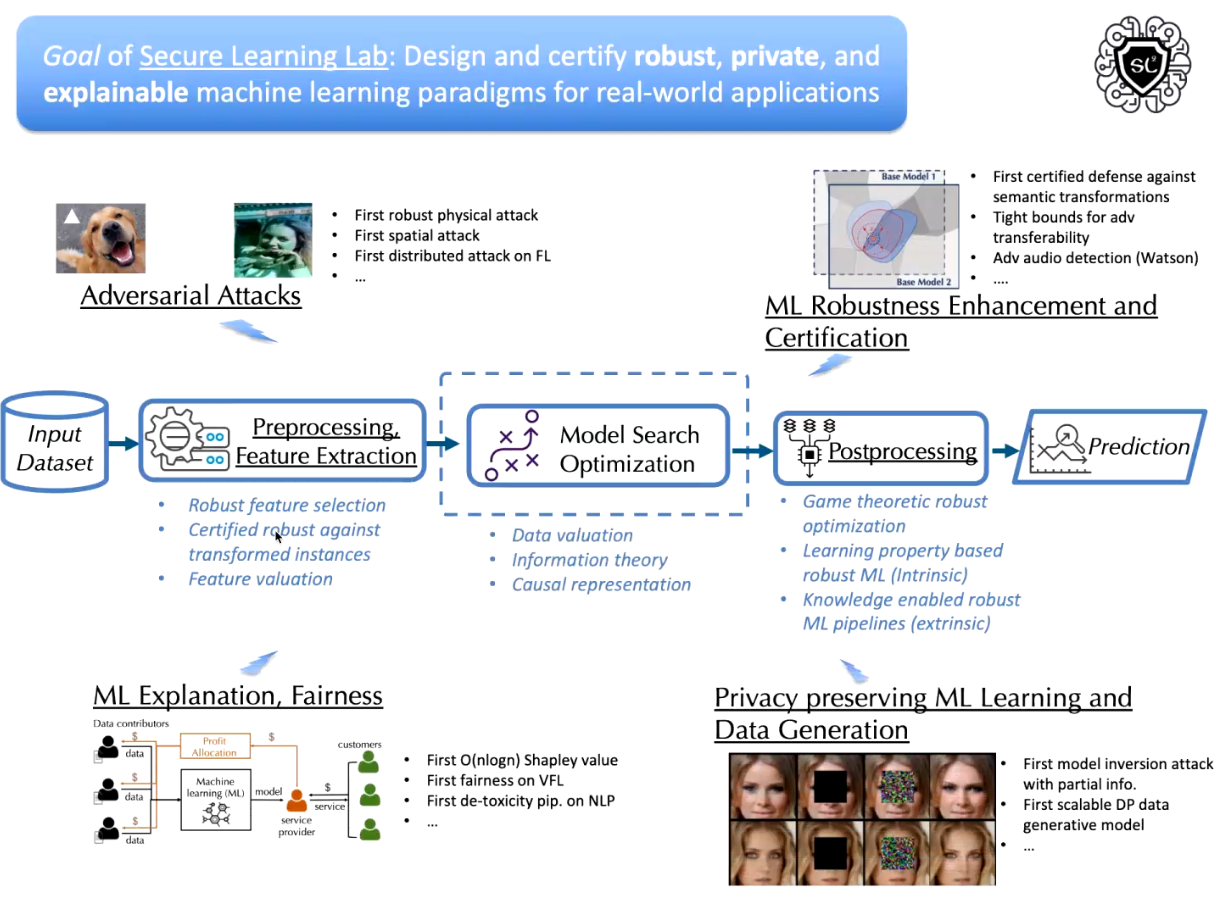

李博教授所在实验室的研究目标是对真实世界中的应用设计具有可验证性的鲁棒、隐私保护、可解释的机器学习算法,并强调了可验证性(certifiable)是走出当前机器学习攻防循环的重要方向。

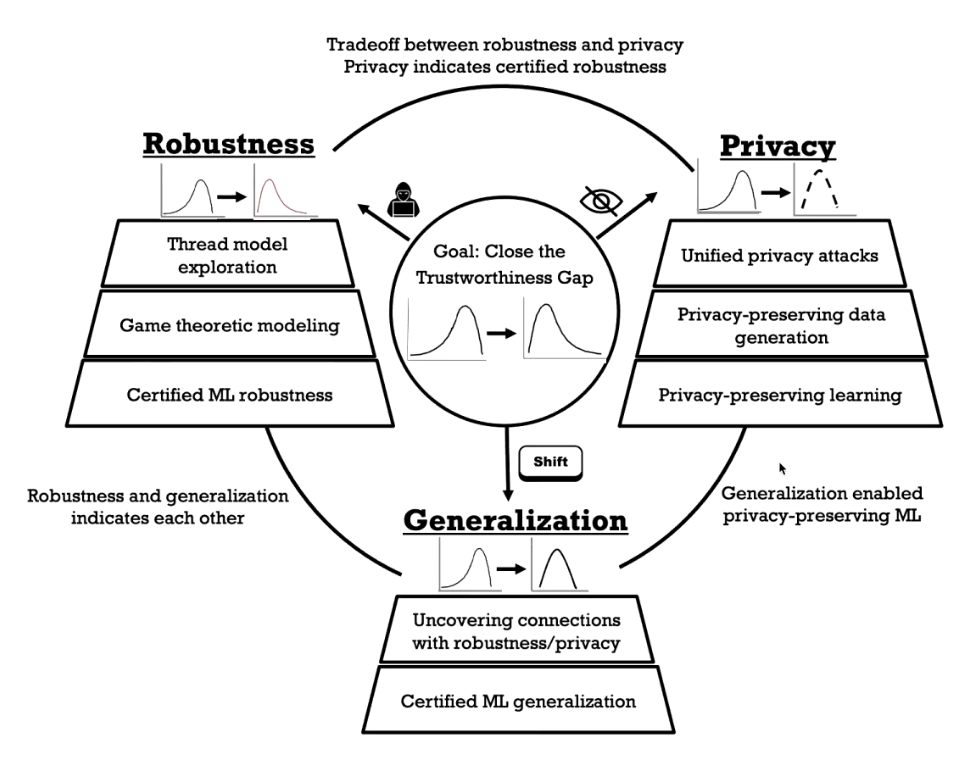

李博教授进一步指出,分布漂移(distribution drift)是可信机器学习中最重要的问题。在分布不均衡下衍生出了所有可信机器学习的问题。例如,机器学习的鲁棒性问题可以被解释为训练与测试过程中的数据分布较为相似,测试数据的分布被恶意攻击者精心修改以达到恶意攻击的目的。再例如,更改训练阶段的数据分布会导致数据投毒、后门攻击等威胁,而更改测试阶段的数据分布会导致对抗样本、回避攻击等威胁。通过博弈论对攻防双方进行建模,可以更好地对AI攻防双方的资源进行分析,刻画其行为,从而为模型鲁棒性提供更多的分析手段。最后,可验证的机器学习鲁棒性有望终结AI安全领域中重复的攻击-防御怪圈,从而在假定攻击者攻击能力的情况下,确保机器学习模型在面对任何攻击均具有一定的鲁棒性下界。

从隐私保护的角度,攻击者希望从加密的数据中获取隐含的敏感训练数据信息,包括模型、成员、原始数据等。防御者希望生成更具有泛化性的,具有隐私保护能力的数据,或使用具有隐私保护能力的模型,来确保机器学习的隐私性。

从机器学习泛化的角度,李博教授指出,随着时间的推移,自然界的一切事物分布都会进行漂移。机器学习在静止环境下学到的数据应该在动态环境中进行有意义的泛化。在机器学习泛化这一角度进行的研究主要包括探究鲁棒性和隐私性之间的关系,以及可验证的机器学习泛化性保证。

李博教授强调,对于鲁棒性、隐私保护和模型泛化能力不能单独研究,而应当着眼这三个领域之间的关系。例如,具有强鲁棒性的模型同样具有强隐私保护能力,具有强隐私保护能力的模型同样更加鲁棒。一旦找到不同领域之间的内在关联,那么一个领域的突破可以在另一领域得到应用。对于鲁棒性和泛化性,对抗迁移性(adversarial transferability)是对抗域泛化能力的充要条件已经得到严格证明。模型泛化能力领域的工作如何指导隐私保护同样是一个十分重要的议题。

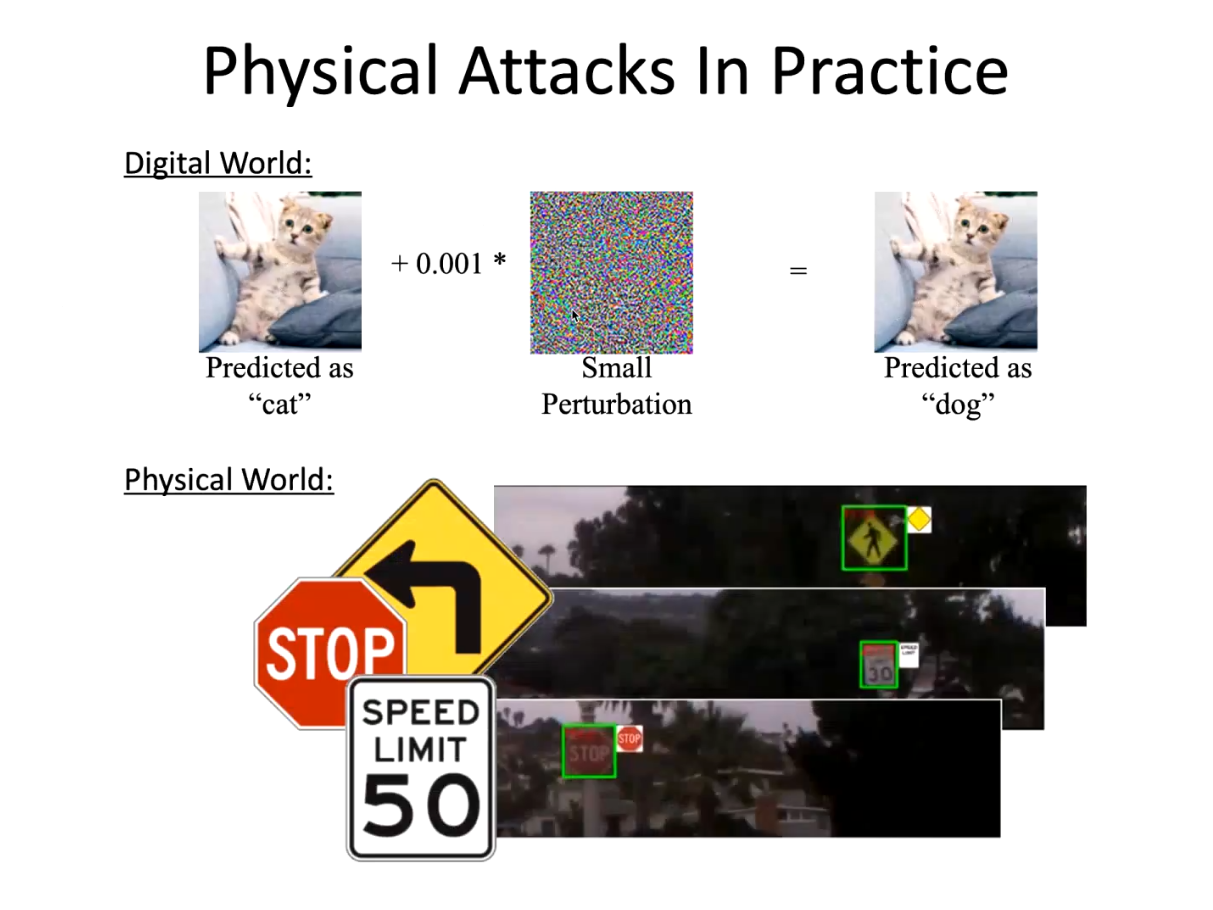

李博教授首先从鲁棒性讲起,提出机器学习模型在数字世界与物理世界均容易受到攻击。其中,物理世界的对抗攻击在真实世界中威胁更大,在自动驾驶等领域会造成严重危害。李教授随后介绍了她在路牌分类、路牌检测、物理世界对抗样本迁移性、LiDAR检测等真实自动驾驶场景下的工作,并指出任何机器学习模型均可以被攻击。

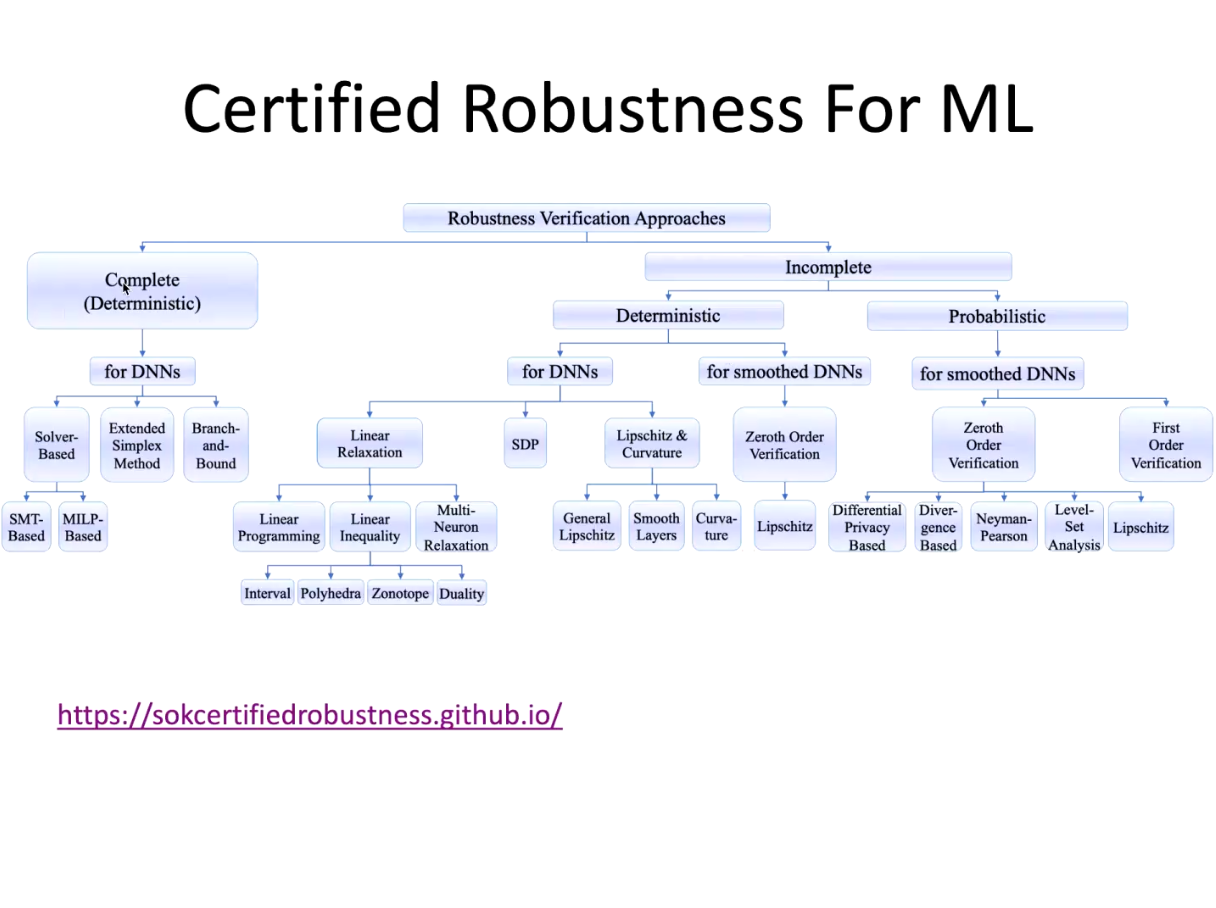

虽然当下许多防御方法被提出,但这些防御方法对基于防御方法本身设计的攻击方法仍然较为脆弱,可以被第二次攻击。李博教授指出,可验证(certified)的机器学习模型在假设攻击者攻击能力的前提下,可以计算出在此攻击能力下机器学习模型准确率的下界,是终结AI安全领域攻击-防御循环的很好的方向,在强调高安全性的场景下具有重要应用。

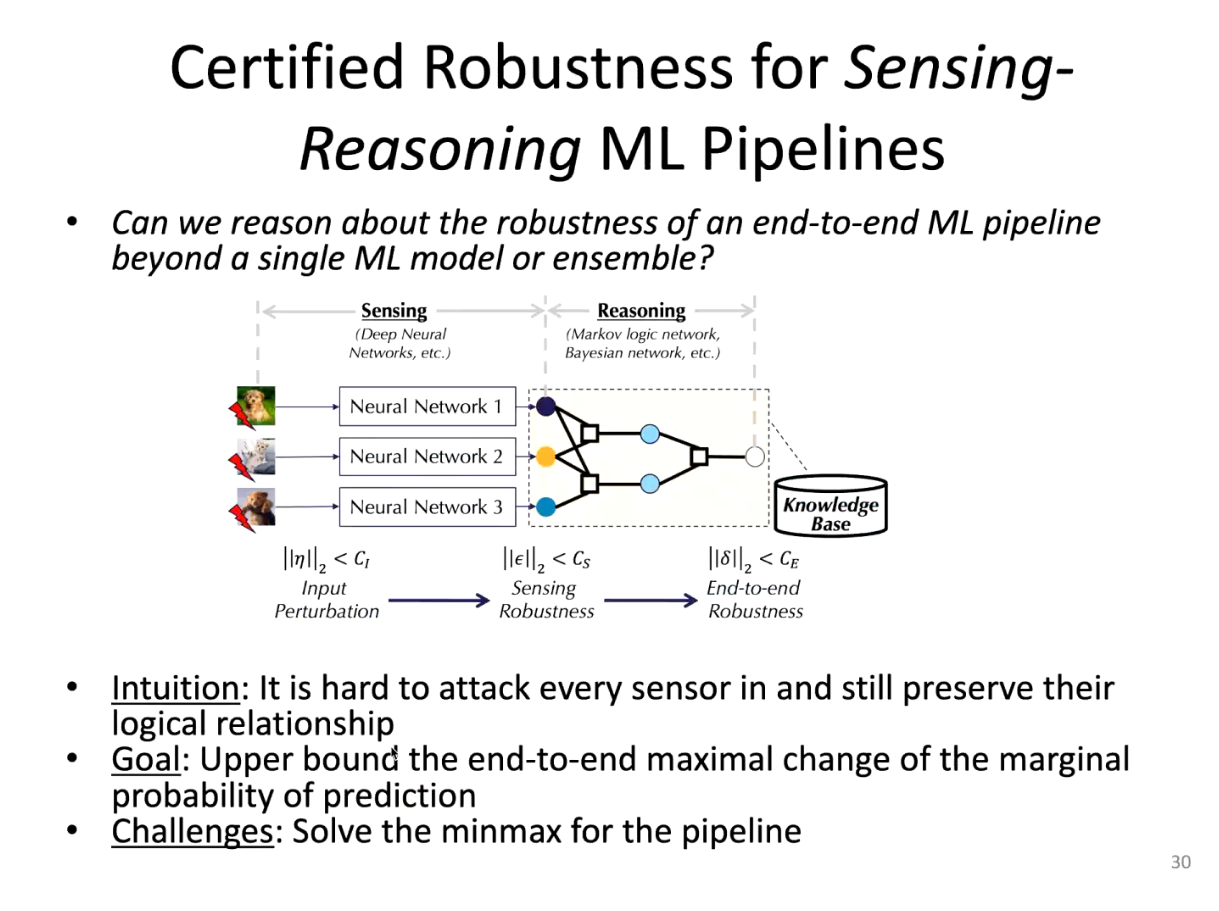

为更好地提高可验证的鲁棒性,李博教授提出机器学习应当理解人的逻辑与人的价值判断。李老师提出,可以将一个神经网络视为一个传感器,并使其他神经网络预测路牌的其他特征,例如,表示STOP的路牌一定是八角形的。这种知识对人而言显而易见,但机器并不一定清楚这一点。当攻击者攻击路牌,使得神经网络将其识别为其他路牌,可以通过路牌的形状等特征将这一错误的结果纠正过来。

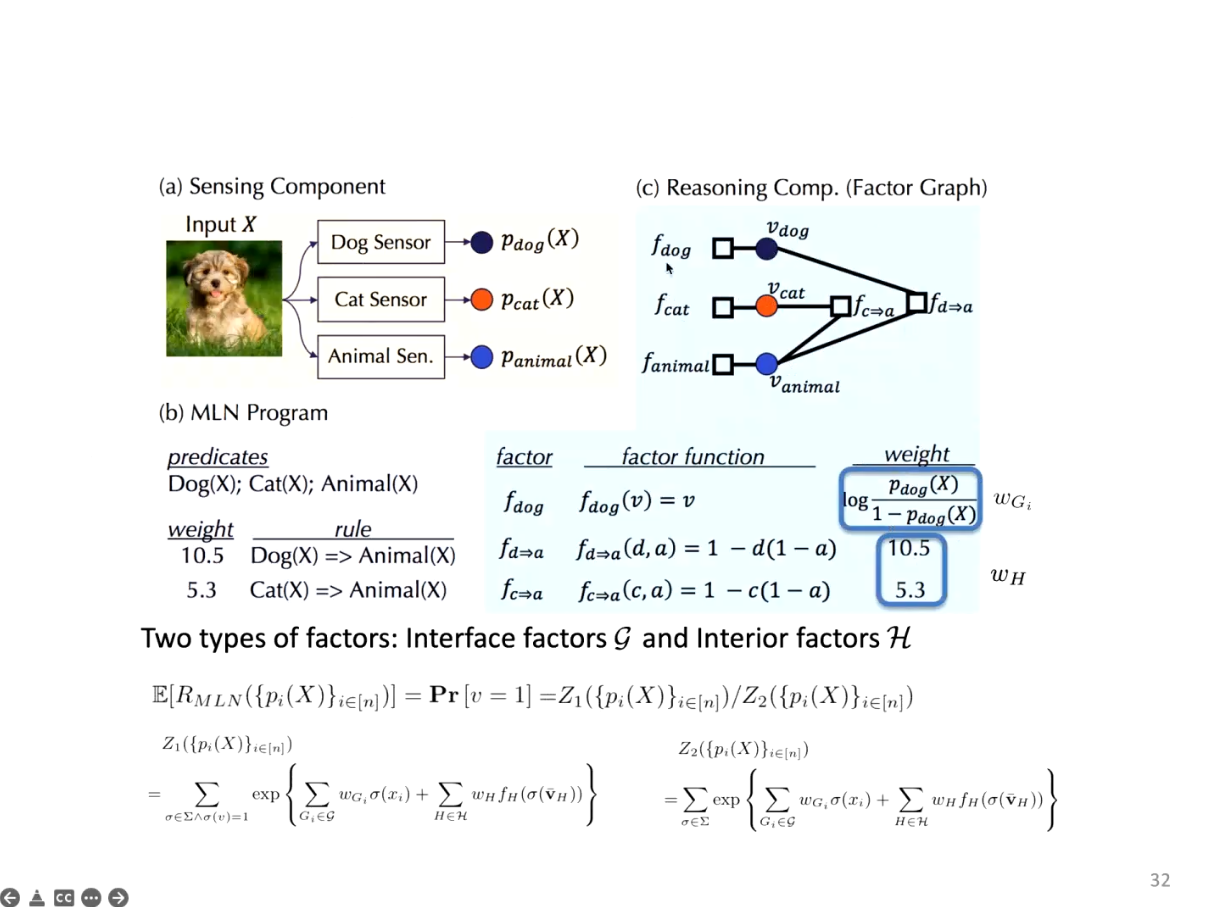

再例如,在最简单的猫狗识别任务中,猫与狗都是动物,从而可以设计判别猫的神经网络、判别狗的神经网络与判别是否为动物的神经网络,从而对于模型推理出可验证的准确率上界与下界。李博教授指出,推理出可验证的准确率本质上是一个#P-complete问题,难以计算,但在合适的假设下可以对其进行简洁优雅的近似。

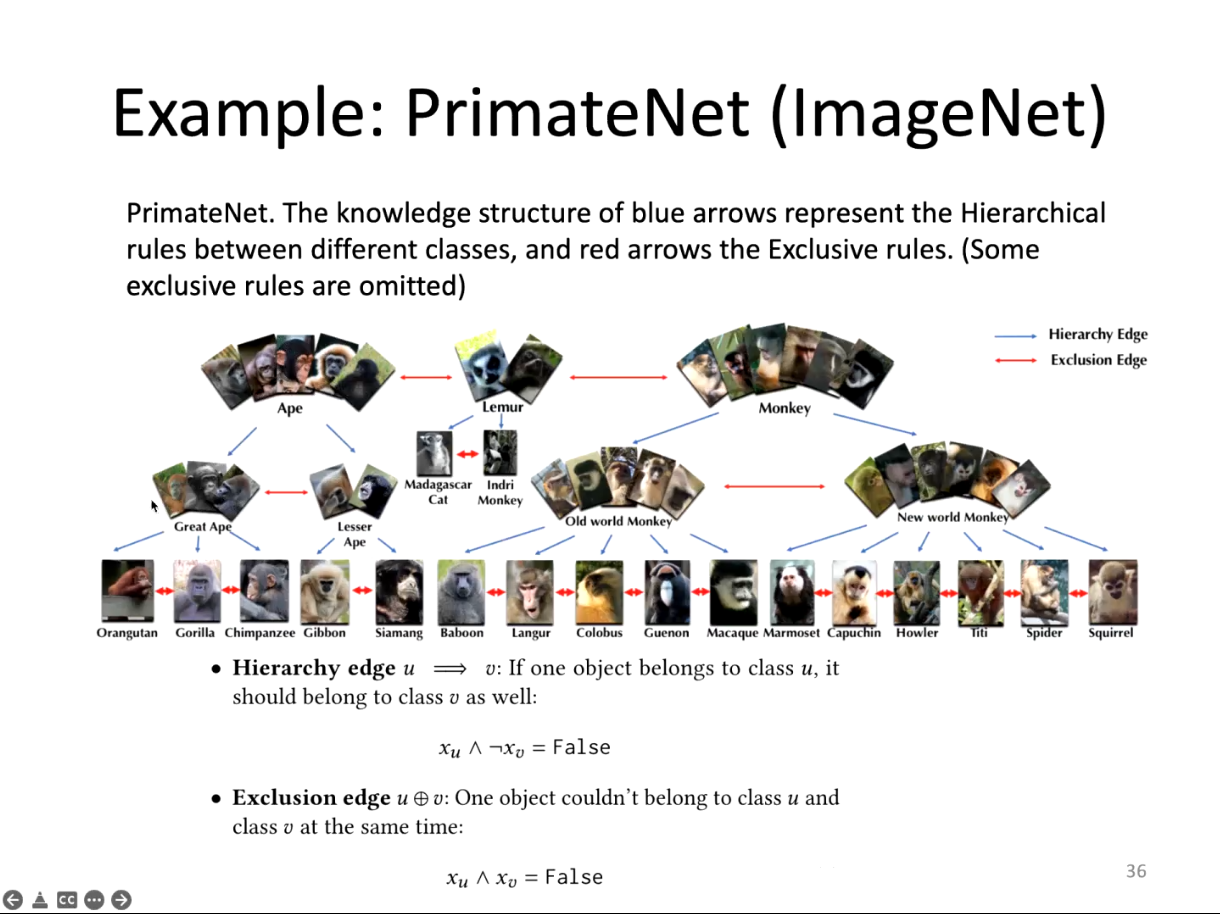

基于逻辑信息,李博教授在ImageNet的子集PrimateNet上使用结合逻辑的方法取得了更高的benign准确率,并大幅提高了可验证的鲁棒性。此外,此方法的有效性也在自然语言处理、物理世界对抗样本防御、自动驾驶等场景下取得了更好的性能,且提高了可验证的鲁棒性。此外,基于逻辑的可信防御方法由于未使用攻击方法进行训练,不依赖特定攻击方法,从而对于各种攻击都能够提供更好的鲁棒性。

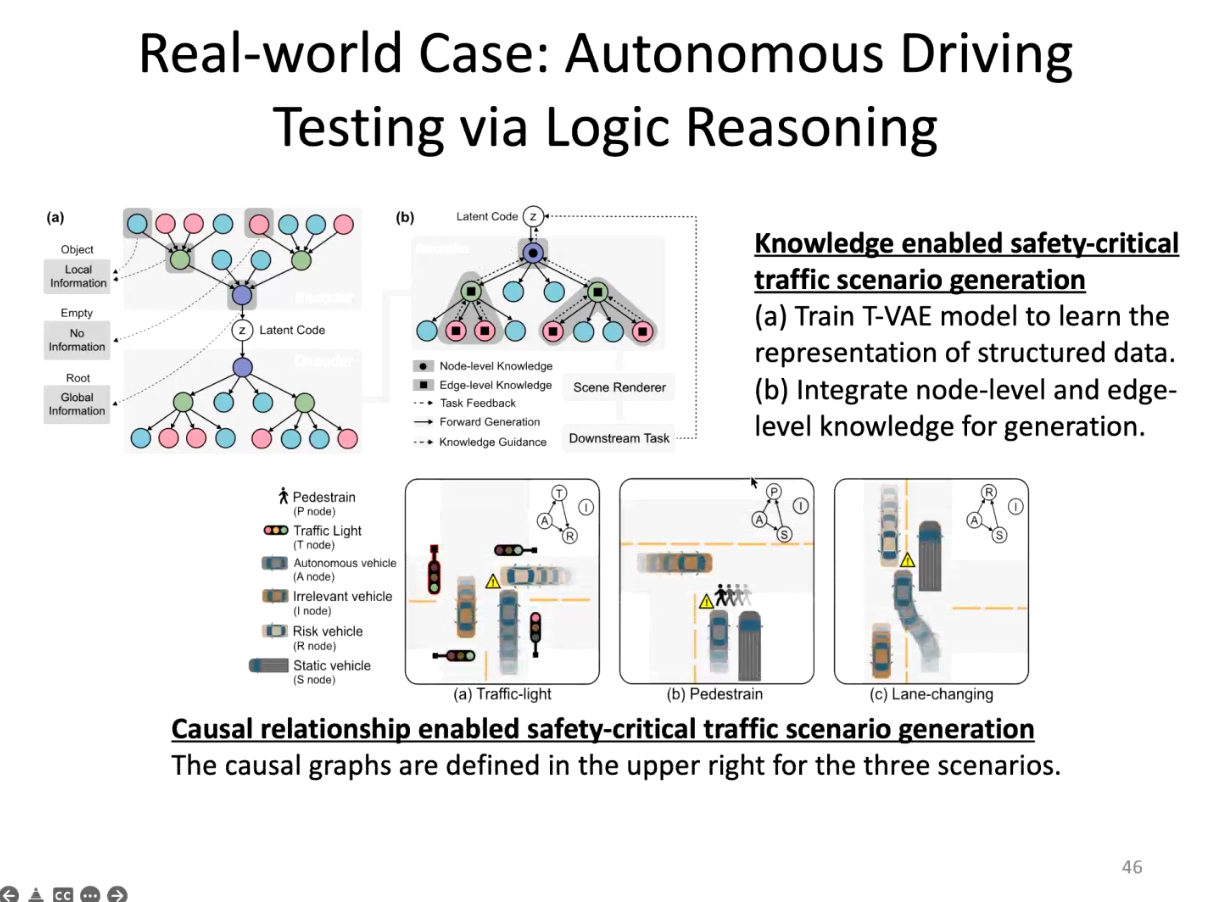

此外,在真实自动驾驶场景下,可以通过逻辑,使用图的形式设计一些基本的安全规则,从而以更高的效率生成大量存在安全隐患的场景。还可以与场景中的因果关系相结合,进一步提高自动驾驶测试的安全性测试效率。

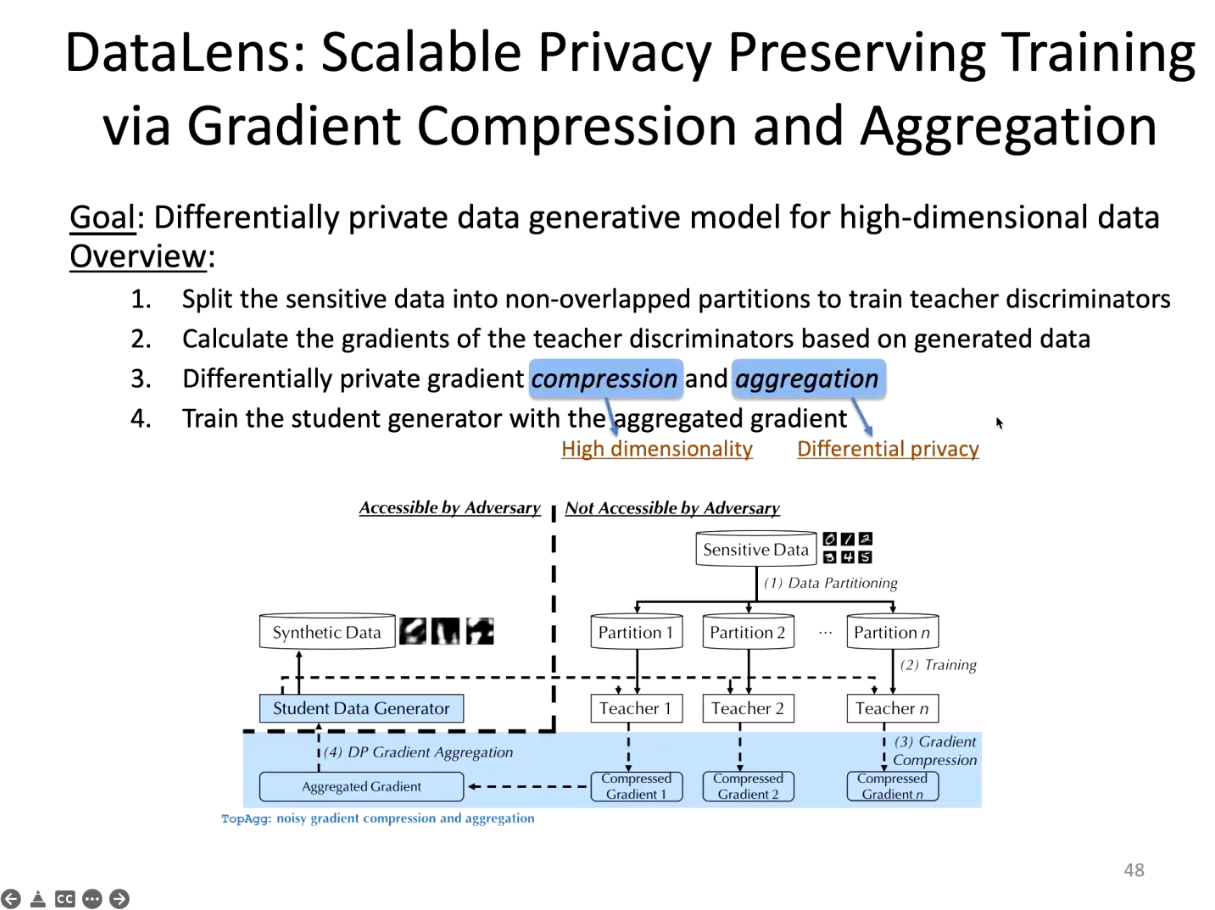

对于隐私保护的资源限制问题,李博教授指出,可以训练多个teacher-student模型,由teacher模型获取原始训练数据,提供梯度,并将梯度进行聚合,由student模型获取梯度并生成具有隐私保护性能的图像,从而生成隐私保护性能可验证的模型。

最后,李博教授给出了与机器学习泛化性能相关的理解。机器学习泛化性的一个重要研究方向在于,如果机器学习出了问题,需要迅速找出这一问题出现在哪个环节。李老师重点介绍了数据估值的重要性,即给数据根据其本身的价值进行定价。

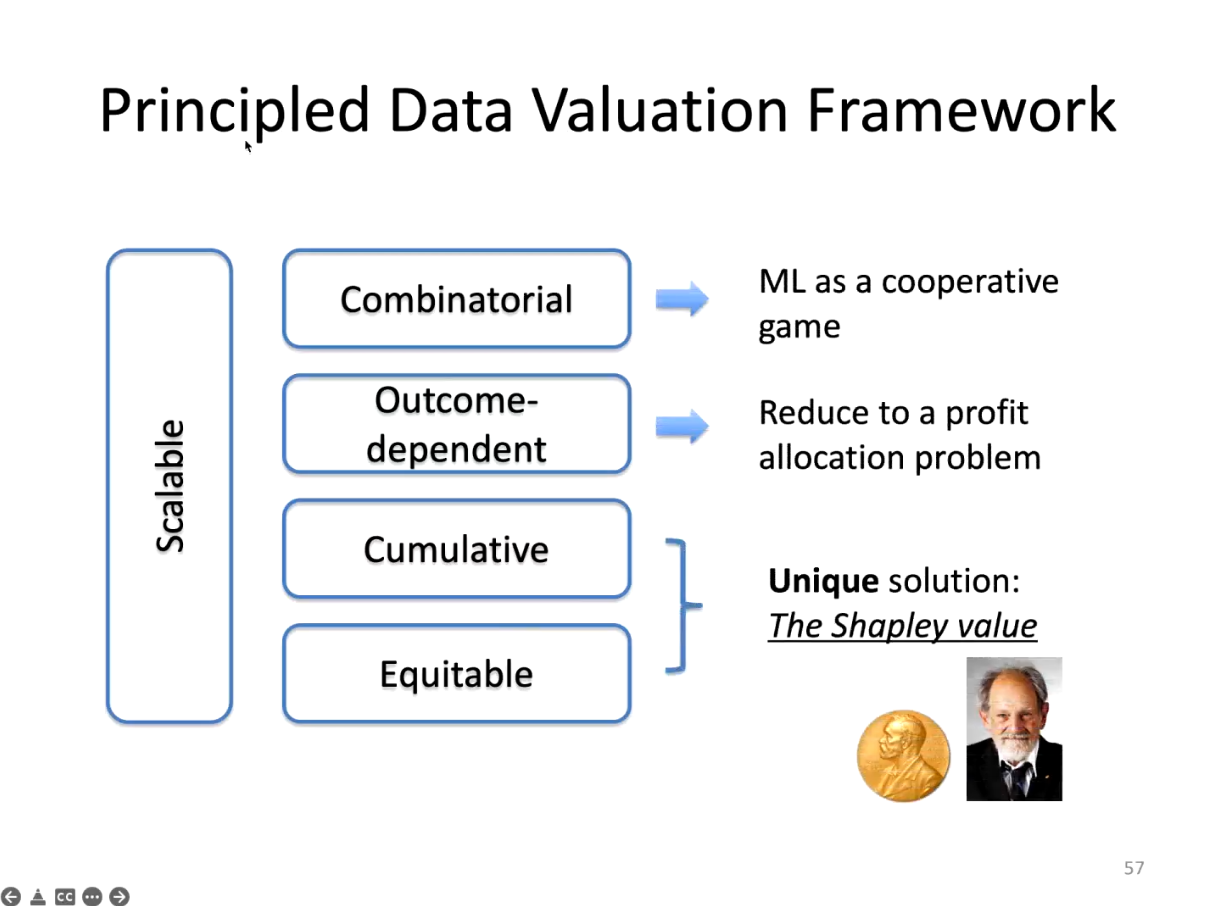

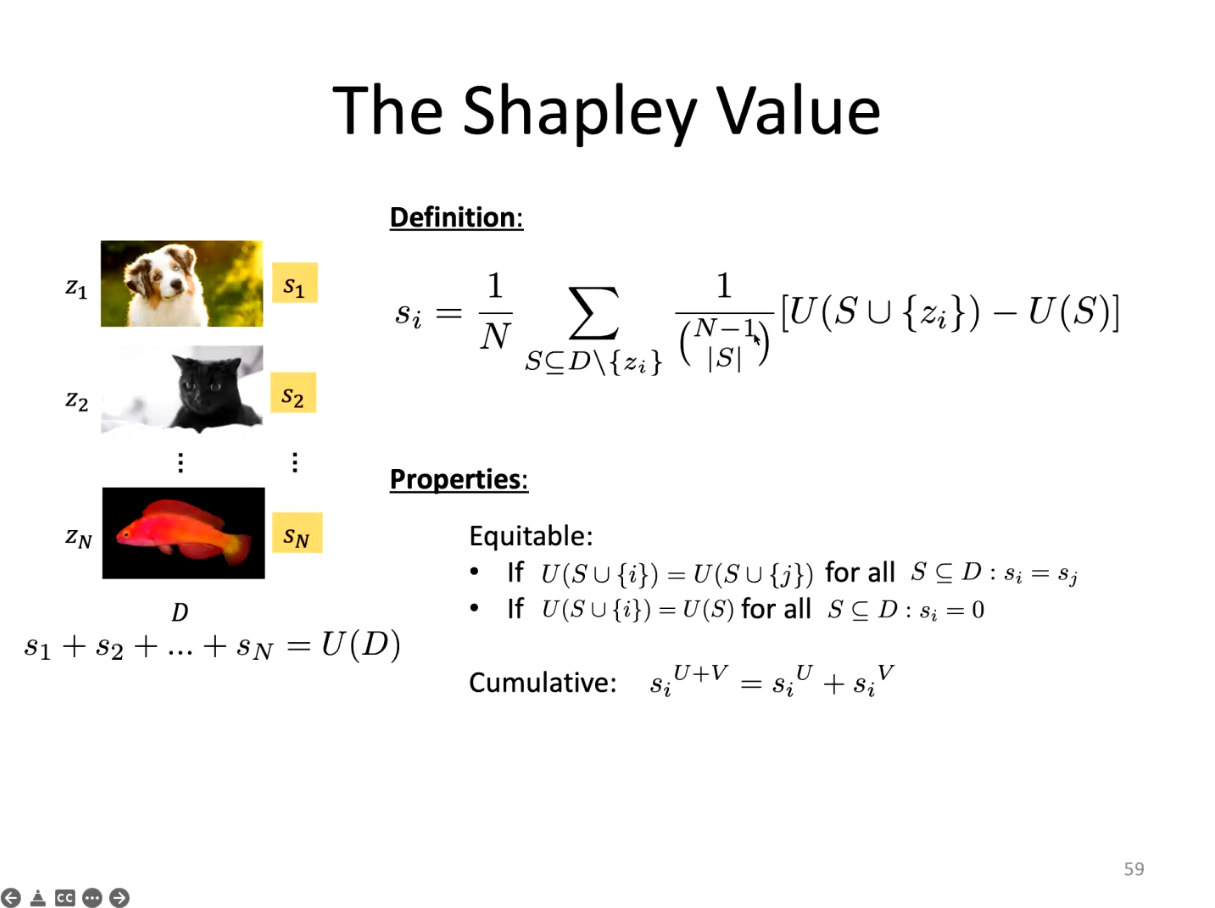

李老师强调,数据定价需要解决诸多问题。Shapley值满足数据定价所需的所有因素,在数据定价场景下具有重要应用。

对数据定价时,可以将每一个单独的数据看成“人”,并对于每一个数据进行单独定价。

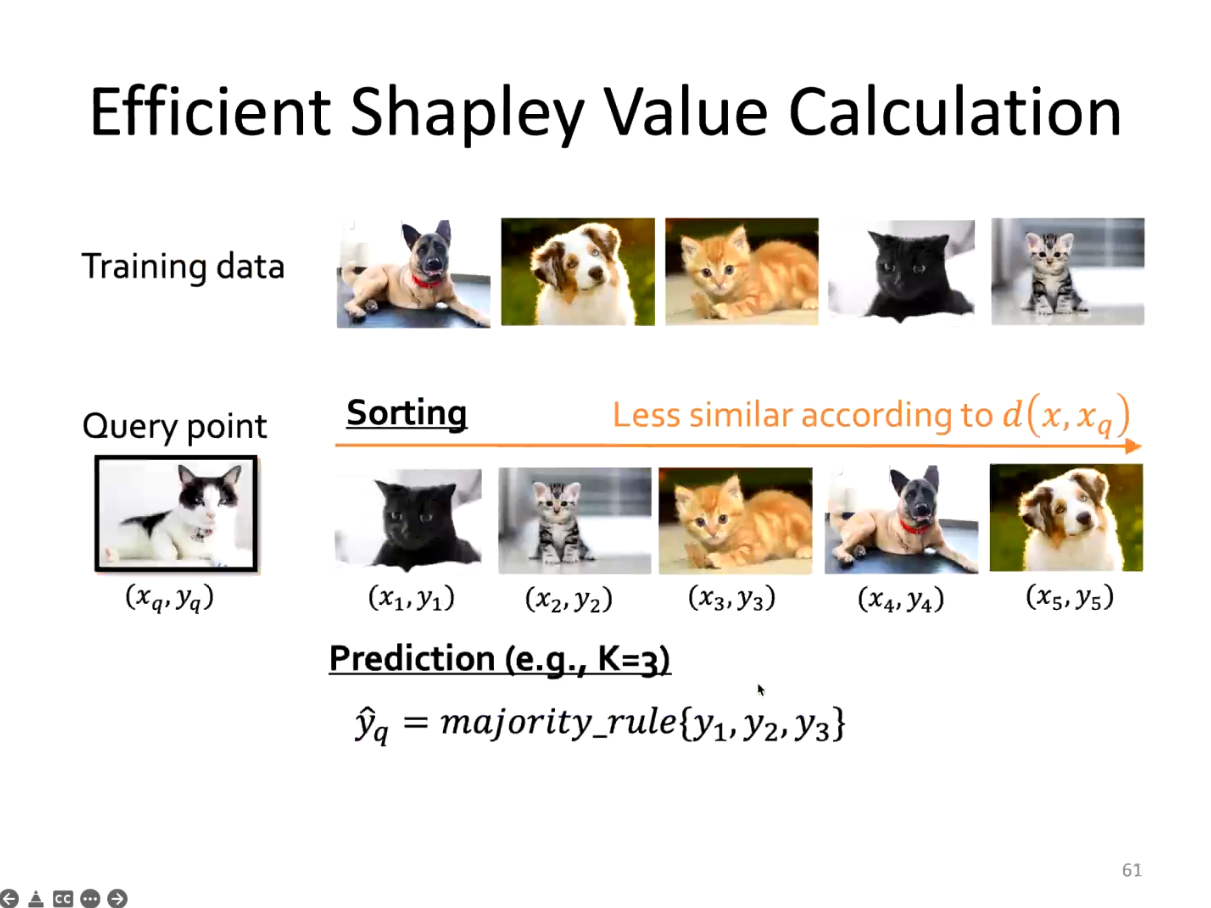

但是,原始的Shapley值计算过于繁琐,复杂度指数增长。李教授与合作者共同提出简便的Shapley值计算方法,从而可以高效地计算Shapley值。

为更好地提高可验证的鲁棒性,李博教授提出机器学习应当理解人的逻辑与人的价值判断。李老师提出,可以将一个神经网络视为一个传感器,并使其他神经网络预测路牌的其他特征,例如,表示STOP的路牌一定是八角形的。这种知识对人而言显而易见,但机器并不清楚这一点。当攻击者攻击路牌,使得神经网络将其识别为其他路牌,可以通过路牌的形状、特征将这一错误的结果纠正过来。

观众提问

Q1: 第一名提问者提出,有没有可能实现绝对的generalization without memorization?理想情况下,如果model只学到general的features,对individual训练数据不做任何记忆,似乎是可以做到绝对的generalization without memorization的,也就彻底解决了隐私问题,同时确保了robustness。请问李老师认为这个有可能实现吗?另外,memorization在machine learning中扮演了什么样的角色?人的分类是基于memorization还是generalization?

A: 李博教授强调,机器学习的最终目的就是泛化。在完美的泛化性下,不存在鲁棒性和隐私性问题。从数据端的角度,可以学习一些更具有泛化性的特征,而非让机器记住一些不是很重要的特征和可疑的关联性质。此外,将人的知识赋予机器也是一种很好的方法:当机器的分类发生错误时,可以使用人的知识对其进行修复。从模型的角度,可以通过smoothness和regularization的方式进行泛化性的增强。基于新的工具、方法和数据,如何提高模型的泛化能力,如何使模型不overcue到一些小的区域中,如何使模型的决策面更为平滑都有待探索。从整体角度而言,可以从数据和模型两个角度对AI进行提升。为实现更好的泛化性能,还需要其他新的知识,新的方法进行进一步的探索。

Q2: 第二名提问者提出,逻辑、符号偏向于离散,但现在的神经网络输出更“连续”的数据,如何将逻辑与神经网络进行结合?

A: 李博教授指出,神经网络具有强大的表征能力,但容易被攻击。逻辑虽然无法对于人的常识进行大规模建模,需要将二者的优点结合起来。逻辑在模型中仅扮演一个鲁棒性的角色,即当主模型未出错时,模型输出正常的结果,当主模型出错时,使用逻辑对于输出进行更新和修复。这样做的好处在于,我们不需要对于所有的逻辑进行建模。

Q3: 第三名提问者提出,除了使用domain知识进行攻击外,是否可以使用domain知识进行攻击,例如对于数据在空间中的分布进行学习,并提出新的攻击方式。

A: 李博教授指出,domain中的知识难以估计,如果对于识别所使用的逻辑,每一个逻辑的输出都是错误的且合理的,这样攻击的难度极大。对于某物体进行的攻击很可能会产生语义上面的变化,从而等价于攻击失败。

Q4: 第四名提问者提出,随着如transformer的大模型被提出,这些大模型在许多任务上都取得了更好的结果,也启发了许多对于transformer鲁棒性的研究。许多人认为,transformer的鲁棒性更好,如何解释transformer的更高的鲁棒性?

A: 李博教授结合她组内的AdvGLUE这一自然语言处理评价基准,指出在评价不同的自然语言处理模型的过程中,没有发现基于Transformer的结构比CNN存在显著的优越性。此外,在李博教授与NVIDIA合作训练的5400亿参数的模型上同样存在鲁棒性缺失问题。大模型的鲁棒性仍然依赖于鲁棒性增强技术。

Q5: 第五名提问者提出,物理世界对抗攻防由于存在环境上的变化,需要添加较大幅度的扰动,对于人的可疑性较大。如何衡量物理世界的对抗扰动的可疑程度,这种扰动的大小和物理世界的自然程度是否存在某种tradeoff?

A: 李博教授提出,物理世界的攻击不可能做到人无法察觉。物理世界对抗样本的可疑程度这一问题与心理等学科相关,涉及到对于人的评估,很难对其进行量化估计。另外,李博教授认为可以从防御的角度设计鲁棒性基准,从而对于物理世界的攻防能力进行评估。

Q6: 第六名提问者提出,更好的泛化性是否指向更强的鲁棒性?另外对于基于语义的攻击,不知道基于逻辑的防御效果如何?

A: 李博教授强调,鲁棒性与泛化性之间的关系是一个非常有趣的问题。鲁棒性中存在adversarial transferability与泛化性中存在domain transferability存在一定的相似程度。目前,基于ImageNet的预训练模型数量较多,评估其domain transfer能力需要较大的算力。因此,基于鲁棒性与泛化性之间的相关关系,可以使用adversarial transferability可以对domain transferability进行快速估计。另外,李博教授指出,鲁棒性与泛化性之间本质上不完全相通,更鲁棒的模型不一定泛化能力更强,但泛化能力更强往往意味着鲁棒性更强。李博教授还指出,对于不同的攻击方式均鲁棒的防御方式是存在的,例如JPEG压缩、模型蒸馏等手段都可以提高模型的整体鲁棒性,基于知识和逻辑的防御也是其中之一。

Q7:第七名提问者提出,模型的结构是否对于模型的鲁棒、隐私、泛化能力存在影响。

A: 李博教授指出,Hinton教授提出的Capsule Net本质上是为了解决robustness的问题,Capsule的本质目的是找到小的patch,并使小patch之间的关系对于常见的空间变化鲁棒。此外,包括BatchNorm等模型架构均对于模型的泛化性存在帮助。模型架构设计的一个整体的原则是使得模型能够学到不变的高质量特征,但如何设计这样的模型还是一个挑战。

Q8:第八名提问者请李博教授给年轻的研究者指出鲁棒性领域未来的研究方向,给出未来研究的建议。

A: 李博教授指出,第一个方向是可验证的鲁棒性。目前,可验证鲁棒性和经验鲁棒性之间还存在较大的gap。解决这一gap需要学习更高质量的特征,设计更好的模型架构,更好地将领域内的信息输入至模型,更好地对于模型进行逻辑推断。第二个方向是研究鲁棒性、隐私保护与泛化性之间的关系。这三个性质之间具有紧密的连接,需要对其进行发掘。第三个是研究因果学习等关系推断方式,即如何寻找图像中物体之间的联系,如何将其加入到模型之中。第四个是对抗攻防的真实世界应用。例如,自动驾驶、智慧城市等应用中本身存在多种可以攻击和防御场景,如何在这些具有独特特征的场景中进行攻防同样具有重大意义。

Copyright © 2025 拉斯维加斯手机娱乐网站 京公网安备 11010802035643号 京ICP备12009057号-1

地址:北京市海淀区中关村东路95号 邮编:100190